Algoritmos em português

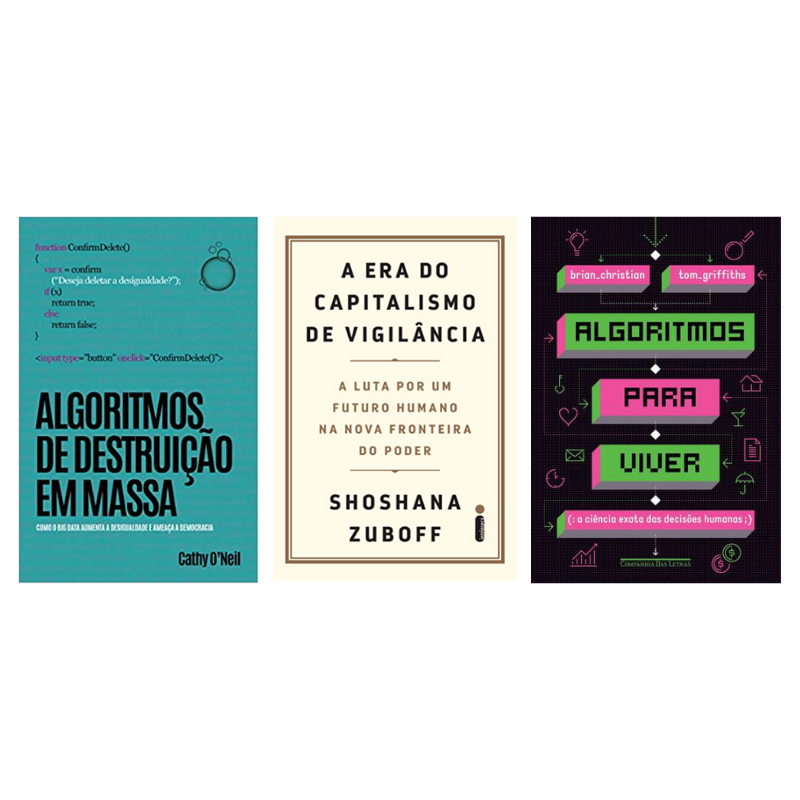

Três livros interessantes para ajudar a entender o mundo “data-driven” em construção agora estão disponíveis também em português. Vamos lá:

Algoritmos de Destruição em Massa (Algorithms of Math Destruction, Cathy O’Neil): pode ser um ponto de partida interessante, cheio de casos e com linguagem fácil, sem excessos matemáticos. Se concentra mais no efeito, no problema, que na estrutura. Cathy O’Neil já é figura conhecida dos documentários “Dilema das Redes” e “Coded Bias”, sempre com seu cabelo azul.

A Era do Capitalismo de Vigilância (The Age of Surveillance Capitalism, Shoshana Zuboff): indicado como um dos livros de 2019 por Barack Obama, mas não apenas isso, também um trabalho sólido sobre os impactos em diversos setores do circuito de produção e negociação de “modificação comportamental” conduzido por empresas de tecnologia.

Algoritmos para Viver (Algorithms to Live by, Brian Christian e Tom Griffiths): esse é mais cascudo, tenta relacionar padrões de escolhas que realizamos no cotidiano com princípios matemáticos. Talvez seja mais indicado para quem está interessado em se tornar cientista de dados. Mais estrutura, menos efeitos sociais.

Conhecendo o Mercado 8ª ed.

Palestra na 8ª edição do evento “Conhecendo o Mercado” e painel com Ricardo Caribé e Vinícius Gambeta.

MktLab EAUFBA

Dia 18/10, vamos conversar sobre efeitos algorítmicos em nosso dia a dia? MktLab EAUFBA será transmitido no canal do YouTube da Escola de Administração da UFBA, às 19h.

Coded Bias

“Coded Bias”, já disponível na Netflix, mostra a imprecisão dos sistemas de reconhecimento facial e seus efeitos para diversos campos da vida cotidiana.

O documentário parte do trabalho da pesquisadora Joy Buolamwini e sua investigação sobre o preconceito generalizado em algoritmos. Passa por casos que mostram as consequências dos diversos tipos de preconceito embutidos nessas tecnologias. E chega à sua jornada na promoção da primeira legislação nos Estados Unidos sobre o uso estatal e corporativo desses sistemas.

Mas sobre o que falamos quando falamos sobre algoritmos?

Quando tratamos do “algoritmo do google”, ou de qualquer outra plataforma, precisamos nos lembrar que o sentido é de uma sinédoque. Ou seja, usamos uma parte para representar o todo, reduzimos uma ampla rede de agentes, tecnologias, crenças, visões de mundo e de eficiência em apenas um termo: o algoritmo.

Por isso, “algoritmo do google”, por exemplo, representa um emaranhado de modelos de negócios, estruturas corporativas, interesses de acionistas e mercados, linguagens de programação, hierarquias empresariais, compliances, regulações externas, preconceitos de centenas de programadores e ainda a arquitetura de milhares de sistemas conectados entre si.

Cada vez mais será preciso expor esses emaranhados e realizar uma contravigilância sobre suas formas de atuação, e principalmente seus efeitos.

Dilema das Redes

The Social Dilemma (2020).

Muitos comentários já foram feitos sobre o documentário, um dos mais vistos atualmente na Netflix. Mas claro, deixo aqui minhas contribuições. São principalmente duas:⠀

⠀

Prmeira, sempre que possível é importante expor os efeitos dos algoritmos. Isso não está claro pra muita gente e quanto mais formas interessantes de expor o problema, melhor. ⠀

⠀

O documentário é divertido, traz analistas importantes para comentar e pode chegar a muito mais gente que não teria acesso fácil a essa discussão.⠀

⠀

Segunda, também é importante expor quem está pensando esses sistemas. Tirando um indiano e talvez duas mulheres, todos os outros são figuras do mesmo tipo. Nascidos nos EUA, formação em instituições de alto padrão, homens, brancos, mesma faixa etária, consumidores dos mesmos serviços e tecnologias. ⠀

⠀

E o problema aí é que esse perfil elabora os sistemas que impactam de forma violenta as relações sociais, a forma de pensar, trabalhar e diversos campos da vida pessoal no mundo inteiro.⠀

⠀

⠀

The Master Algorithm

No livro “The Master Algorithm”, o autor Pedro Domingos, professor de ciência da computação na Universidade de Washignton, apresenta uma hipótese central: “A existência de um algoritmo único capaz de descobrir todo o conhecimento – passado, presente e futuro – a partir de dados, um algoritmo-mestre.”

Hoje algoritmos estão no centro de nossa vida cotidiana. Não apenas nos resultados do Google, sugestões de livros e filmes da Amazon e Netflix, seleção de posts do Twitter e Facebook ou filtros de spam do Gmail. Mas também no controle de carros, elevadores, catracas de acesso a edifícios, pulseiras de monitoramento de dados pessoais (wearables), dispositivos de comunicação e incontáveis sistemas de bancos, companhias aéreas, fábricas e negócios. E cada vez aprendem mais e mais com os dados que processam continuamente.

O avanço em sua capacidade de aprendizado levou ao surgimento dos learning algorithms. A estes são colocados os dados de entrada e os resultados desejados. Mas não a forma como chegar a esses resultados. Os learners, como também são chamados, são capazes de produzir, testar, descartar e refinar hipóteses. São algoritmos capazes de criar outros algoritmos. Nos learners está a base para o machine learning, conceito no qual computadores podem produzir seus próprios programas.

Mas por que estamos criando máquinas capazes de desenvolver seus próprios aprendizados? Podemos nos concentrar em problemas imediatos, como encontrar a cura do câncer, por exemplo. De forma resumida, considere duas dificuldades no tratamento do câncer. A primeira é que a doença se desenvolve provocando uma série de outras complicações relacionadas a ela. Não há um padrão, mas uma grande variedade de formas do avanço da doença. Também não há um tipo único de reação aos medicamentos usados no tratamento. Cada paciente reage de uma forma particular a partir da condição de seu corpo. Está aí a segunda dificuldade. Com a evolução do machine learning, algoritmos podem se tornar capazes de desenvolver estratégias particulares de tratamento para cada paciente a partir das características de sua doença e da condição fisiológica do seu corpo. E ainda formular medicamentos individuais para cada um deles. Enquanto grupos de cientistas humanos poderiam levar quase uma vida para testar centenas de hipóteses, os learners realizariam o mesmo trabalho em frações de um segundo.

O livro traz comparações sobre a forma de funcionamento e as diferentes propriedades de computadores e do cérebro humano, que servem de pistas sobre como o aprendizado das máquinas pode se desenvolver com o tempo. Computadores fazem cálculos através de uma pequeno passo de cada vez. Como resultado eles precisam de muitas etapas para realizar algum processamento útil. Mas por outro lado, essas etapas podem ser realizadas de forma muito rápida porque seus transistores podem ligar e desligar bilhões de vezes por segundo. Já o cérebro humano pode executar um grande número de cálculos em paralelo, com bilhões de neurônios trabalhando ao mesmo tempo. Mas cada um desses cálculos é lento porque os neurônios podem disparar na melhor das hipóteses mil vezes por segundo.

Comentei com o Prof. Rodrigo Firmino, da PUC-PR, sobre a idéia do algoritmo-mestre. Sua resposta foi rápida: “Será Deus?”. Para os religiosos, com certeza, sim. Deus pode ser a fórmula que dá sentido a todos os eventos e seres vivos. Se um algoritmo define “o que fazer” e “como fazer”, a idéia de um algoritmo-mestre depende de uma determinada perspectiva. Para os biólogos essa resposta pode estar no DNA, para os neurocientistas no cérebro humano, e para os matemáticos numa equação universal, que contém a sequência Fibonacci, sua linha de ouro e todas as outras equações. Talvez os físicos pensem nas leis de Newton ou leis quânticas ainda desconhecidas. Para o inventor britânico Charles Babbage, pioneiro da computação, ainda no século XIX, Deus não criou as espécies, mas o algoritmo para sua criação. A evolução, portanto, seria o verdadeiro algoritmo-mestre.

“The Master Algorithm” não é um livro de leitura simples para os que não pertecem ao campo da ciência da computação, embora muitas questões e idéias sejam simplificadas para um público mais amplo. São apresentadas diferentes escolas de machine learning e como cada uma delas busca seu algoritmo universal. Os exemplos e suas explicações, no entanto, são muito interessantes para criar um panorama das transformações produzidas pelas “máquinas que pensam” em um futuro bastante próximo.

p.s.: Atualização em 07/08/16: IBM’s Watson AI saved a woman from leukemia

The Cleaners

Algoritmos podem identificar certos padrões em imagens, mas em alguns casos ainda é necessário uma avaliação humana sobre seu conteúdo. ⠀

Por isso, plataformas como Facebook, Twitter e YouTube contratam empresas para remover conteúdo indesejado em suas redes. ⠀

Nessas empresas, centenas de jovens, de 18 a 20 anos, passam até 10h por dia vendo e classificando milhares de imagens perturbadoras. Violência, abusos, pedofilia, terrorismo são os temas mais comuns. ⠀

O serviço é chamado de “digital cleaning”, e os trabalhadores são os “content moderators”. A cada imagem apresentada na tela eles devem apenas escolher entre deletar ou ignorar em poucos segundos.⠀

As empresas de “digital cleaning” estão localizadas em países distantes das sedes das plataformas de conteúdo. Muitas delas nas Filipinas. ⠀

E não há nenhum tipo de proteção aos “content moderators”, principalmente em relação aos efeitos psicológicos causados pela constante visualização de milhares de imagens chocantes.

“The Cleaners” é um documentário sobre a rotina de trabalho desses moderadores de conteúdo. ⠀

E sobre o outro lado traumático das imagens felizes publicadas nas mídias sociais. ⠀

Weapons of Math Destruction

“Armas de destruição matemática” são modelos ou algoritmos usados para quantificar diversos campos do nosso dia a dia. ⠀

Desde lugares para a realização de uma blitz policial até a capacidade de pessoas pagarem empréstimos ou cometerem crimes. Avaliações desse tipo passam cada vez mais a serem realizadas por modelos matemáticos.⠀

Mas esses modelos não são apenas racionais e objetivos. Há muito do preconceito, racismo e subjetividade de seus criadores embutidos em seus códigos.⠀

O resultado pode ser devastador criando um loop de resultados que reforçam desigualdades financeiras e de oportunidades.⠀

SCREAM 2019

Participação em três mesas do SCREAM 2019, sobre escola criativa, dados e mercado publicitário.

Whatsapp para Campanhas Políticas

Curso no Instituto Nacional de Ciência e Tecnologia em Democracia Digital – INCTDD.

O Futuro do Trabalho

Palestra na II Jornada do Conhecimento do Colégio Marízia Maior, Salvador/BA.

CONECTA 2019

Palestra sobre “Smart Cities” na V Semana de Arquitetura e Urbanismo.

Mercado 4.0

Oficina “Criatividade e o Futuro do Trabalho” na 1ª edição do Mercado 4.0. Dia 03/09, no Shopping Paralela.

SER Festival

Palestra “O Futuro do Trabalho” na programação do SER Festival, discutindo algoritmos, robôs e a automação de atividades humanas.

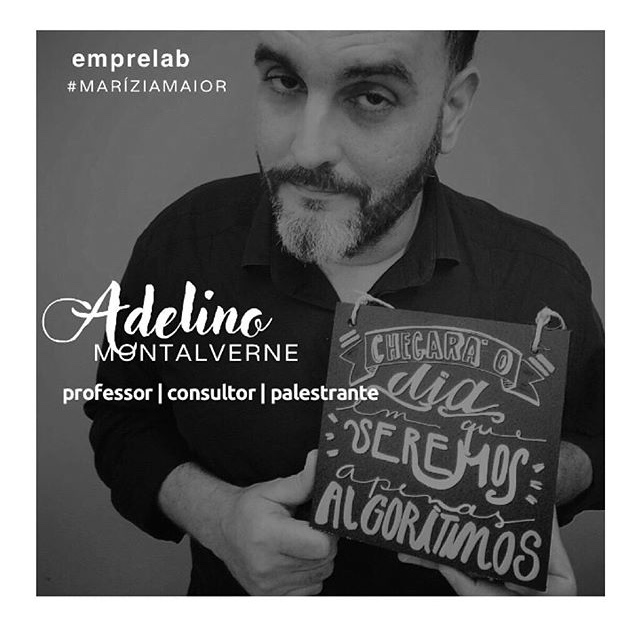

Emprelab School 2018

15 equipes de estudantes do ensino médio apresentam soluções para desafios atuais.